Ricostruire i passaggi che hanno portato da un mondo abiotico alle primissime forme di vita, dando il via all’evoluzione degli organismi unicellulari, è un compito improbo a cui gli scienziati si dedicano fin dai tempi del “

brodo di Miller”.

Sul "quando" le stime sono un poco meno nebulose.

Le primissime evidenze della vita sulla Terra risalgono a circa 3,7 miliardi di anni fa (dati basati su

rocce verdi trovate in Groenlandia) anche se si stima che la vita fosse già presente 3,9 miliardi di anni fa, quando la Terra iniziò a raffreddarsi fino a una temperatura alla quale esisteva allo stato liquido. La comparsa delle prime cellule (procarioti) è datata intorno a 3,5 miliardi di anni fa mentre per gli eucarioti bisogna bisogna aspettare 1,8-2 miliardi di anni fa (vedi l'articolo "

Alla ricerca del LUCA").

Piacevole la sorpresa di trovare un articolo (breve ma adeguato) su un quotidiano che per sua natura, aggravata a volte da faciloneria senza revisione, non è un luogo ideale in cui trovare temi scientifici trattati adeguatamente. Il Foglio ospita una sezione curata da Enrico Bucci che è invece la dimostrazione di come, volendo, sia possibile trattare temi specialistici in modo adeguato.

In questo ultimo Bucci riassume gli studi più recenti centrati sulla dimostrazione della possibilità, nella Terra primordiale, di reazioni spontanee capaci di produrre i "mattoni" della vita e la capacità di questi mattoni di autoassemblarsi in strutture sempre più complesse.

Scopo non è dimostrare COME la vita abbia avuto inizio (impossibile a meno di avere una macchina del tempo) ma che certi eventi siano potuti avvenire.

Prendo spunto dalla bella idea di Bucci per approfondire un poco il tema aggiungendo alcune informazioni e referenze

Possiamo iniziare il viaggio dalla accertata presenza di molecole organiche complesse come i ribonucleosidi (i mattoni del RNA) durante il primo periodo

Adeano. Presenza confermata (anche) dal ritrovamento di queste molecole sui meteoriti, rocce vecchie come il Sistema Solare.

Si ipotizza che i ribonucleosidi possano formarsi anche nello spazio attraverso una serie di reazioni chimiche che coinvolgono semplici molecole organiche come la formaldeide, l'acido cianidrico e l'acqua, tutte molecole presenti sia nelle nubi interstellari che nelle comete. In presenza di radiazione (cosmica o ultravioletta) tali molecole possono essere

indotte a reagire formando ribosio, il precursore dei ribonucleotidi.

La scoperta dell'aminoacido glicina in una cometa nostra vecchia conoscenza (vedi

qui) ha evidenziato come anche gli aminoacidi possano formarsi nel mezzo interstellare (

Ioppolo et al, e

S. A. Krasnokutski et al).

Sulla Terra primordiale, condizioni simili potrebbero essere esistite nelle bocche idrotermali grazie alle alte temperature e alla presenza di vari gas e minerali.

Altra ipotesi sulla formazione dei ribonucleotidi è quella sottesa alla ipotesi del mondo a IPA, secondo cui gli idrocarburi policiclici aromatici (IPA) avrebbero svolto un ruolo importante nell’origine della vita, fungendo, nell'ipotetico stadio del "mondo a RNA", da precursori della sintesi di acido ribonucleico. A conferma dell'ipotesi la recente scoperta che tali composti sono estremamente abbondanti nelle nubi molecolari presenti nello spazio (vedi "Un mega idrocarburo nella nube del Toro").

La disponibilità di ribonucleosidi non sarebbe stata però sufficiente. Era necessario che fossero presenti le forme "attive", i ribonucleotidi trifosfato (rNTP) cioè le forme a cui l’aggiunta di tre gruppi fosfato li rende reattivi e idonei per la polimerizzazione. Nella cellula questo processo è mediato da processi che sfruttano l’energia prelevata dal “cibo” (molecole organiche scisse nei componenti base usati per la generazione di energia, conservata sotto forma chimica in molecole reattive come ad esempio ATP). Una volta usato per alimentare una reazione chimica l'ATP perde un gruppo fosfato diventando ADP e deve essere ricaricato usando l'energia chimica accumulata. Stesso discorso per attivare i "mattoni", rNTP e NTP, necessari alla sintesi di RNA e DNA, rispettivamente.

Chiaramente tali reazioni catalizzate da enzimi non potevano esistere nel mondo prebiotico per cui la “attivazione” doveva essere mediata da processi spontanei conseguenti all’interazione tra molecole preesistenti.

Kim e Benner nel 2021 dimostrarono che in condizioni simili a quelli esistenti nell’Adeano, tra cui la presenza di borato, nichel e di un donatore di gruppi fosfato, la sintesi abiotica di rNTP era possibile.

Il ruolo di nichel e borato è catalizzatore e stabilizzatore, rispettivamente.

Una volta "comparsi" i rNTP il passo successivo è stato verosimilmente la loro polimerizzazione a formare filamenti di RNA sufficientemente lunghi dal possedere una qualche attività catalitica (vedi in tale proposito il concetto di

ribozima).

Nel 2022 lo studio di

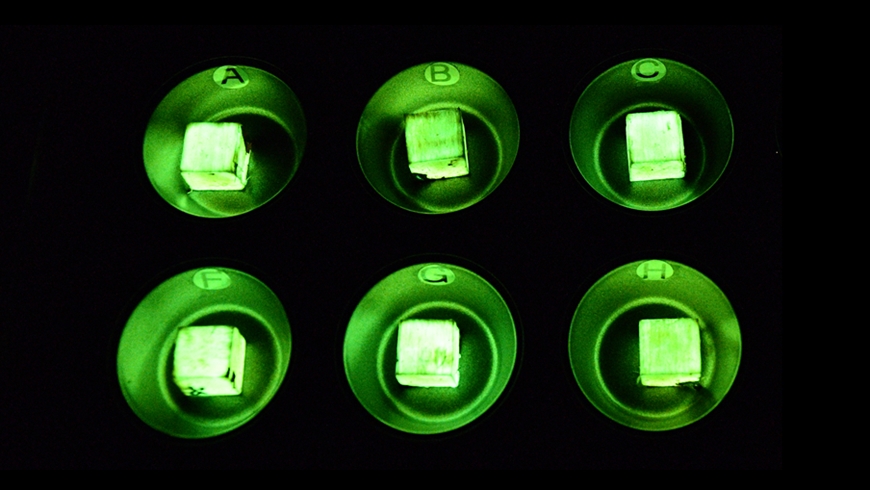

Jerome e collaboratori provò che in presenza di materiale vetroso di origine vulcanica (come

diabase,

basalto e

gabbro prodotti in seguito al rapido raffreddamento della lava) i rNTP potevano polimerizzare spontaneamente in catene di RNA di lunghezza fino a 300 nucleotidi.

Processo che, detto per inciso, avrebbe potuto avvenire anche su

Marte, un tempo pianeta vulcanicamente attivo.

A questa nozione aggiungiamo i risultati presentati nel 2020 da

Tjhung e colleghi che dimostrano che (alcune delle) molecole di RNA prodotte, rientranti nelle dimensioni di cui sopra, erano in grado di sintetizzare copie funzionanti di sé stesse. Il lavoro successivo di Jerome et al. evidenziò attività catalitiche paragonabili ad una ribozima polimerasi e a ribozima ligasi di classe I capaci nel complesso (polimerizzazione e ligazione) di autoreplicarsi

La ligasi è un enzima (o ribozima in questo caso essendo fatto di RNA) capace di catalizzare la formazione di un legame chimico. La polimerasi catalizza la polimerizzazione dei singoli mattoni (monomeri).

La bassa fedeltà di copiatura delle ribozima polimerasi (e in generale delle RNA polimerasi) è un volano di mutazioni che ha conseguenze evolutivamente importanti. Se da una parte i ribozimi "figli" prodotti avranno una certa probabilità di non funzionare (o male) dall'altra l'alta frequenza di mutazioni faciliterà il processo di autoselezione (leggasi evoluzione) di ribozimi più affidabili.

Punto questo indagato in un lavoro del 2021 (

Portillo et al) in cui si sono impiegate tecniche di

evoluzione diretta (riproducono in laboratorio la selezione naturale). I ricercatori dimostrarono che erano sufficienti 52 generazioni per ottenere, spontaneamente, ribozimi polimerasi migliorati in efficienza e fedeltà, capaci di generare sequenze di RNA più lunghe.

Pesiamo questo dato ottenuto in poche generazioni con le decine o centinaia di milioni di anni a disposizione nella Terra primitiva per formare molecole di RNA più complesse ed efficienti nella replicazione (vedi concetto di

fitness genetica)

Un articolo del 2022 (

Mizuuchi et al) mostra che oltre all’evoluzione verso forme più efficienti si è andata via via affinando la cooperazione tra molecole di RNA che ha portato a ribozimi interdipendenti e a reti di replicatori: l’interazione porta ad un aumento della stabilità complessiva del sistema, favorendo i replicatori coinvolti (vantaggio evolutivo).

Cooperazione che, come mostrato nell’articolo di

Müller et al. (2022), avrebbe coinvolto non solo molecole di RNA ma anche corti polimeri di aminoacidi (peptidi), a loro volta capaci di interagire tra loro.

Le molecole ibride RNA-peptide appaiono più stabili e attive rispetto ai singoli RNA o peptidi e come tali avrebbero rappresentato una fase intermedia cruciale nella transizione dal mondo a RNA a un mondo dominato da ribosomi (macromolecole ribonucleoproteiche in cui avviene avviene la sintesi di proteine partendo dall’informazione contenuta nell’RNA) primitivi.

Un evento chiave per l'emergere del codice genetico e del flusso di informazione RNA-proteine.

I processi ora delineati avvenivano però in un ambiente liquido privo di “barriere”, con il risultato di rendere le interazioni rare e limitate all’instaurarsi di condizioni locali permissive (in una nicchia nella roccia sul fondo dell’oceano o una pozza di acqua calma in una laguna). Riproducibilità e frequenza su tempi non su scala di eoni erano possibili solo se gli ingredienti si fossero trovati all’interno di una struttura protetta; dovevano in altre parole formarsi delle protocellule, ambienti sufficientemente stabili da separarsi dall'instabilità esterna dell’Adeano.

Nulla a che vedere, sia chiaro, con le attuali cellule che anche nella forma batterica hanno un buon grado di complessità. Queste protocellule dovevano essere strutture sferiche delimitate da molecole lipidiche anfipatiche capaci di autorganizzarsi in uno stato energicamente favorevole mediante una membrana a due strati, delimitante l'interno acquoso in cui erano intrappolati ribozimi e peptidi. Vantaggio della formazione di compartimenti interni era l’aumento di concentrazione locale che rendeva possibile reazioni chimiche anche senza l’ausilio di catalizzatori biologici (enzimi).

P

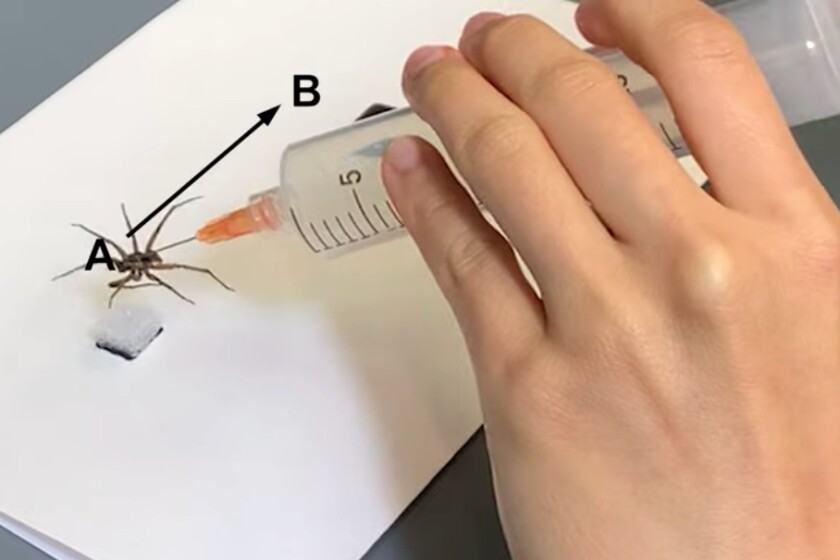

roof of concept verificato nel 2021 nell’articolo di

Köksal et al. Fosfolipidi e acidi grassi che dovevano essere presenti nel mondo prebiotico hanno mostrato capacità di auto-organizzarsi come protocellule in presenza di superfici minerali.

Ultimo studio sul tema quello di

Saha et al. (2024) in cui si dimostra come l’inglobamento dell’RNA all’interno delle protocellule, oltre a migliorare stabilità e attività catalitiche, accelera l’evoluzione.

Nel dettaglio si è visto che ribozimi incapsulati in vescicole (micelle, liposomi, etc) evolvono più velocemente rispetto a quelli non incapsulati, selezionando forme sempre più attive. Il fenomeno descritto, noto come effetto di Matthew,

Effetto di Matthew. Chiunque sia in una situazione di vantaggio (in questo caso, i ribozimi più efficienti) tende ad acquisire più vantaggi rispetto alla concorrenza aumentando così la fitness. Le protocellule come sinonimi di acceleratori/incubatori di impresa o se vogliamo metterla in sociologia "chi più ha, più avrà".

Una ultima notazione riguarda i lipidi che compongono le membrane cellulari. A differenza degli altri "mattoni" della vita che abbiamo dimostrato potere essere sintetizzati anche nello spazio, i lipidi devono essere prodotti. Un importante tassello che manca nel quadro oggi delineato. La soluzione a questo dilemma viene dai cosiddetti

condensati biomolecolari, cioè aggregati spontanei e non delimitati da membrane presenti all'interno delle cellule sia nei procarioti che negli eucarioti, e che svolgono ruoli chiave (ribosomi, etc). Questi aggregati avrebbero potuto formarsi nella Terra primordiale creando una sorta di proto-cellule in cui le reazioni di sintesi (anche dei lipidi) diventavano possibili.

***

Alcuni libri sul tema

/bright-stars-in-our-night-sky-3073632_final2-41045308721d4b668d3913527a01c276.gif)