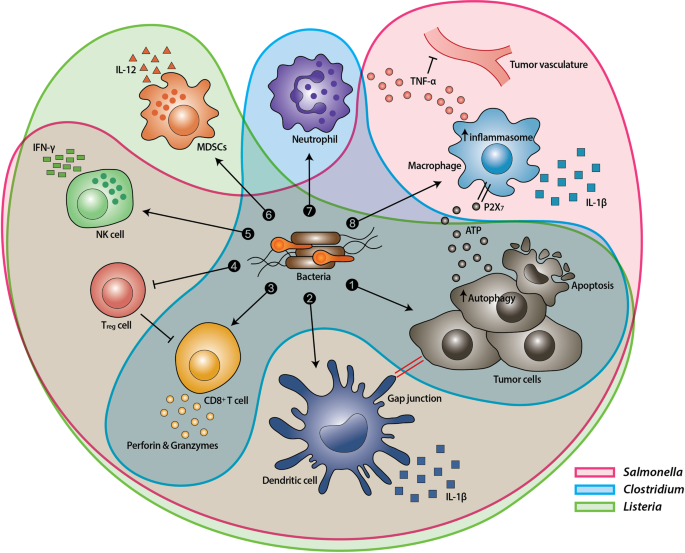

Il misterioso effetto terapeutico può essere compreso se si pensa ad un "effetto collaterale" dell'infezione. In sintesi, la presenza dei batteri in prossimità del tumore causa il reclutamento locale del sistema immunitario che "scopre" la presenza di cellule aberranti attaccandole.

Nota. Ricordate che i tumori insorgono nei nostri tessuti fin dalla nascita ma nel 99,9% dei casi le cellule anomale vengono scoperte e rimosse dal sistema di sorveglianza. Capita che queste cellule anormali riescano a mimetizzarsi tra le cellule normali e / o divengano capaci di "spegnere" le cellule di pattuglia non appena queste le riconoscono. Questo è il primo passo che consente il loro sviluppo e l'acquisizione di caratteristiche sempre più invasive fino al tumore conclamato e alla metastasi.

|

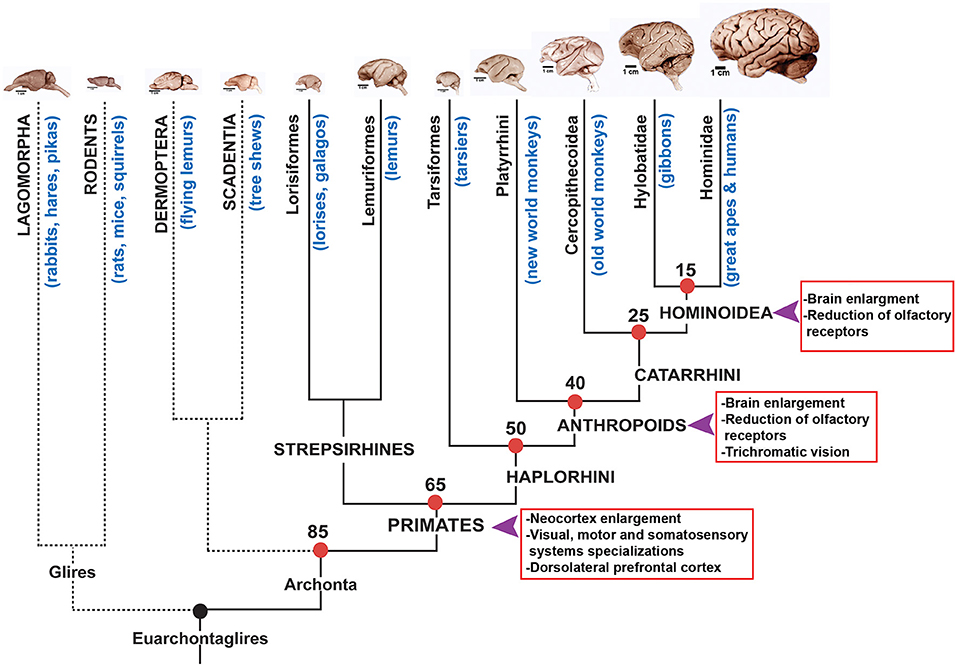

| La presenza di batteri in un tumore induce una reazione immunitaria "forzando"uno stato infiammatorio anche dove prima c'era un tumore invisibile (image credit to: Jung-Joon Min et al, (2019) EMM) |

|

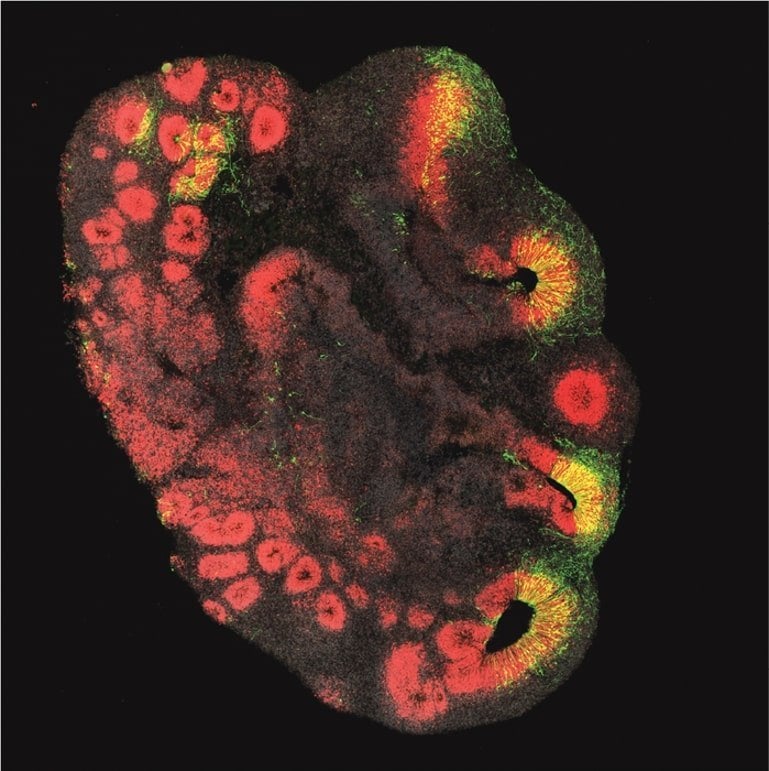

| Un macrofago (in verde) mentre passa tra le cellule tumorali. Molto spesso i macrofagi vengono "silenziati" dalla cellule tumorali con segnali che a lui risuonano come "siamo cellule normali, puoi proseguire". Quando questo avviene non solo il macrofago non attacca e "dissuade" anche i linfociti dall'iniziare l'attacco, ma fornisce alle cellule tumorali anche fattori di crescita. I batteri potrebbero sabotare questa connivenza attivando lo stato infiammatorio (image credit: Memorial Sloan Kettering Cancer Center) |

Ma l'idea di riuscire ad ottimizzare l'approccio in modo da renderlo sicuro, controllabile ed efficace è sempre rimasto nella mente dei ricercatori.

"batteri programmati per colpire le cellule cancerose".

L'alta espressione del recettore CD47 è stata sfruttata per la diagnostica e per lo sviluppo di terapie equiparandola ad una "bandierina" che segnala "questa è una cellula tumorale ed è un bersaglio".

Facile in ambito diagnostico. L'analisi istochimica distingue chiaramente il forte segnale di CD47 sulle cellule tumorali rispetto a quello debole delle cellule normali.I ricercatori della Columbia University guidati da S. Chowdhury, hanno cercato un'altra strada, usando l'alta espressione tumorale di CD47 come un "faro" per guidare in loco un "missile terapeutico" basato sui batteri. Il sistema è stato messo a punto su modelli murini.

La situazione si complica quando si vuole sviluppare un'arma che utilizzi CD47 come guida. Facciamo un esempio semplice e immaginiamo una molecola capace di riconoscere ed occultare CD47, così da rimuovere il lasciapassare immunitario e favorire l'attacco dei macrofagi. L'utilizzo sistemico di tale molecola andrebbe a colpire anche le cellule normali, causando effetti collaterali tra cui anemia e trombocitopenia.

Passaggio preliminare la duplice modifica genetica del batterio Escherichia coli:

- reso capace di attivare una procedura di autolisi in modo sincrono con i suoi simili una volta raggiunta una certa densità;

- trasformato in un "container", il cui carico sono molecole capaci di bloccare CD47.

I batteri riescono a raggiungere la densità voluta nel tumore essendo questa un'area immuno-privilegiata, cioè a bassa densità di azione immunitaria a causa delle contromisure che il tumore attiva durante la sua evoluzione. La lisi in sincrono locale evita il rilascio delle molecole effettrici nei tessuti sani, minimizzando così il rischio di effetti collaterali. La sincronizzazione è basata sul sistema di comunicazione batterico del quorum sensing.In sintesi, due sono i meccanismi immunitari che tale trattamento vuole stimolare:

- la presenza di batteri vivi innesca una infiammazione locale nel tumore che richiama le cellule immunitarie;

- i macrofagi si "accorgono" della presenza di cellule anomale (CD47 bloccato) e iniziano a fagocitarle, rilasciando nel contempo citochine che richiamano i linfociti T infiltranti. Una volta attivati, i linfociti continueranno l'opera di bonifica anti-tumorale in altri tessuti rimuovendo metastasi altrimenti invisibili.

- regressione tumorale;

- assenza di metastasi

- netto aumento del tempo di sopravvivenza.

Un tema in parte correlato è quello dell'utilizzo di virus per infettare e distruggere le cellule tumorali in modo diretto (virus litici e/o ingegnerizzati per esprimere una tossina) o indiretto (attivazione risposta immunitaria locale). Vedi sul tema la review di K. Harrington et al (Nat. Rev. Drug Discovery - 2019)

Altro esempio di virus "benefici" è quello dei batteriofagi (i virus dei batteri) che hanno avuta una recente rinascita come trattamento dei batteri multiresistenti agli antibiotici; dato che i fagi coevolvono insieme ai batteri, possono agire come "antibiotici" in grado di autoadattarsi alla comparsa di ceppi resistenti alla infezione (articolo precedente sul tema --> qui).