Questo vale per i virus influenzali e il Sars-CoV-2 (compresi i coronavirus prossimi venturi)

"Too much information is even worse than no information at all," mi disse un saggio. Io voglio correggere questo detto cercando di recuperare dalla "nuvola" scientifica (life sciences & astronomia in primis) alcune fra le notizie più interessanti ma sconosciute ai più, a causa dell'appiattimento dei media generalisti sulle stesse identiche notizie di agenzia.

CC

Questo opera di above the cloud è concesso sotto la Licenza Creative Commons Attribuzione 3.0 Italia.

Based on a work at scienceabovetheclouds.blogspot.com.

The Copyright Laws of the United States recognizes a “fair use” of copyrighted content. Section 107 of the U.S. Copyright Act states: “Notwithstanding the provisions of sections 106 and 106A, the fair use of a copyrighted work (...) for purposes such as criticism, comment, news reporting, teaching, scholarship, or research, is not an infringement of copyright.”

Any image or video posted is used according to the fair use policy

QUALUNQUE link in questa pagina rimanda a siti sicuri!! SEMPRE.

Volete aiutare questo blog? Cliccate sugli annnunci/prodotti Amazon (se non li vedete, disattivate l'Adblocker mettendo questo sito nella whitelist. NON ci sono pop up o script strani, SOLO Amazon). Visibili in modalità desktop! Se poi decidete di comprare libri o servizi da Amazon, meglio ;-)

Dimenticavo. Questo blog NON contiene olio di palma (è così di moda specificarlo per ogni cosa...)

Infezioni respiratorie e rischio attivazione tumori dormienti

Il boom in borsa dei farmaci antidiabetici che fanno anche perdere peso

Alla fine dello studio durato poco meno di 3 anni e mezzo è stato inserito un periodo di 17 settimane senza farmaco così da avere un quadro completo della funzione farmacologica e della durata dell'effetto nei mesi successivi. Vero che al termine del trattamento i pazienti hanno iniziato a riprendere peso mostrando una alterazione dei parametri in senso diabetico ma il fattore di rischio di sviluppare il diabete propriamente detto è risultato inferiore dell’88% rispetto a prima di iniziare il trattamento. Un trattamento che come per tante terapie della sindrome metabolica deve essere continuativo, sebbene (i dati lo confermano) possa essere interrotto senza grossi problemi.

Tali osservazioni avevano convinto molti medici a prescriverla off-label a individui obesi. Ricordo che in assenza di studi clinici dedicati un farmaco (approvato per altro scopo) NON può essere prescritto come terapia per altra patologia. La FDA ha autorizzato l’uso come farmaco per la perdita del peso solo nel 2023, nella formulazione nota come Zepbound.

Nei soggetti sani il livello dell’ormone si abbassa durante il digiuno, il che è innesca lo stimolo della fame. Negli individui obesi il livello si mantiene basso e questo spiega la loro ricerca di cibo anche subito dopo avere mangiato. Ulteriori dettagli a fine articolo **.Nota aggiuntiva. Uno studio recente ha dimostrato come l'atto di ingoiare induca il rilascio di serotonina (ormone associato alla sensazione di piacere) che spiega come, in individui predisposti, il mangiare invece di indurre sazietà porti ad un rinforzo del piacere di mangiare.

Pesticidi comuni e rischio Parkinson

|

| Credit: neurosciencenews.com |

A parte la loro tossicità nei neuroni dopaminergici, i pesticidi identificati hanno poco in comune sia nella struttura/classe di molecole che come gamma di utilizzo

Detto per inciso è curioso che i tanti avversari degli OGM (in uso da 10 anni e senza alcun elemento di tossicità trovato) non abbiano invece alcuna remora nel consumare vegetali trattati con prodotti simili. Curioso visto che il vantaggio principale della agricoltura OGM è di ridurre al minimo i trattamenti chimici.

In ambito scientifico ogni ipotesi per essere validata necessita di studi di causa-effetto. L'unica strada percorribile quindi è stata quella di integrare i dati da colture cellulari con quelli ricavati da animali.

I farmaci "psichedelici". Una risorsa di cui però si ignora il meccanismo di azione

|

| Illustration by Kasia Bojanowska |

|

| Libro in cui si tratta, con piglio giornalistico/antropologico delle 4 principali piante con attività psicotropa (credit: Amazon) |

Vero che anche gli antidepressivi classici, come il Prozac (fluoxetina), si legano al recettore, ma il legame è fino a 1000 volte più debole rispetto agli psichedelici, il che spiega perché uno sembri migliorare i sintomi in poche ore, mentre gli altri richiedano molti mesi.

Ad esempio alcune condizioni patologiche come autismo e schizofrenia, potrebbero (talvolta) derivare da un’eccessiva plasticità del cervello. Inoltre, tutti i tipi di droga, comprese la cocaina e le anfetamine, possono indurre una sorta di plasticità e tutto noi conosciamo l'effetto negativo (fisico e psichico) indotto da queste sostanza.

In un esperimento di somministrazione ai topi di queste sostanze (MDMA, ibogaina, LSD, ketamina o psilocibina) si sono osservati risultati comportamentali interessanti. I topi trattati sono diventati più disposti a dormire in uno scompartimento con altri (chiaro segno di riduzione di stress) e l’effetto è durato per settimane. Poiché i topi adulti non tendono a cambiare il loro comportamento sociale, la scoperta suggerisce che i farmaci psichedelici sono stati in grado di riaprire il “periodo critico”, la fase in cui i topi giovani imparano ad associare la socialità a qualcosa di positivo. Nello stesso studio si è anche scoperto che i neuroni degli animali trattati hanno iniziato a esprimere un insieme di geni coinvolti nel rimodellamento della matrice extracellulare, una zona che che funge da “malta” tra i neuroni: il rimodernamento libera i dendriti e gli assoni dando loro la capacità di formare nuove connessioni.

Vero anche che l'esketamina, la versione modificata della ketamina approvata per la terapia antidepressiva (necessita di dosaggio molto inferiori e questo evita gli effetti collaterali della droga), non è inferiore alla ketamina per cui è possibile agire sulla riduzione degli effetti allucinogeni.

Una misurazione del problema placebo viene dai ricercatori di Heifets Labs che hanno sviluppato un modo per quantificare l’intensità dell’effetto placebo; il team di ricerca ha testato la ketamina su persone sottoposte a intervento chirurgico che erano state messe sotto anestesia e incapaci di sperimentare gli effetti dissociativi del farmaco. Le persone che escono dall’intervento chirurgico spesso sperimentano sintomi di depressione accentuati. Ma i ricercatori hanno scoperto che, indipendentemente dal fatto che un paziente avesse ricevuto ketamina o un placebo, i suoi sintomi miglioravano se pensavano che avrebbero potuto assumere il farmaco: l’aspettativa stessa di ricevere il farmaco stesso avrebbe potuto migliorare il loro umore.

E se la prossima pandemia venisse da un fungo?

|

| Un castagno infetto |

I castagni americani sono invece più resistenti ad un altro fungo, Phytophthora cambivora, di cui soffrono i castagni europei e che causa il cosiddetto mal dell'inchiostro.

Sia chiaro, non tutti i funghi sono nocivi come ben dimostrano le forme commestibili (o che aiutano nella preparazione di cibi e bevande come i lieviti) e soprattutto i funghi saprofiti, fondamentali nella decomposizione degli organismi morti, rimettendo i circolo gli elementi essenziali per la vita. Ad esempio il legno degli alberi defunti, tra i materiali più resistenti alla decomposizione, rimarrebbe li per “sempre” se non fosse per l’azione combinata di di batteri e (su tutto) funghi.

Esempi in tal senso (dette specie aliene ... per un dato territorio) sono purtroppo innumerevoli e vanno dallo scoiattolo grigio al pitone in Florida (ne ho scritto QUI), dai gamberetti ai funghi, ... . QUI un elenco più esaustivo.

* una affermazione che è implicitamente vera, ricalcante il famoso principio antropico: se non fosse così (i funghi non avessere questo punto debole) noi non saremmo qui a parlarne ma come mammiferi saremmo diventati loro cibo preferito fin dai tempi della comparsa del "sangue caldo" nei vertebrati

Cito la Candida auris che nell’ultimo decennio si è adattata diventando capace di infettare le persone fino a diventare un fattore di rischio concreto nelle strutture sanitarie (vedi qui), già prone per loro natura a facilitare la selezione e diffusione dei superbatteri. Anche altre infezioni fungine umane, come la coccidioidomicosi potrebbero presto seguire in questo adattamento.

- Il Fusarium è un fungo che oggi minaccia piante già di loro sensibili come i banani (ricordo che si tratta di fatto di cloni creati per produrre frutti commestibili senza semi e proprio per tale assoluta omogeneità esposti al rischio di attacco distruttivo su larga scala)

- Lo Pseudogymnoascus destructans è responsabile della strage di pipistrelli colpiti dalla sindrome del naso bianco, che li fa letteralmente morire di fame in quanto ne consuma, durante il periodo invernale di stasi, tutte le riserve di grasso. I cadaveri degli animali alati affollano molte caverne negli USA.

- Batrachochytrium dendrobatidis ha preso di mira le rane in America Centrale, una strage ora spostatasi in altre aree dove si osserva un drastico calo della popolazione degli anfibi.

Dall'analisi delle missive di "Dracula" l'analisi del suo stato di salute e l'origine della (famose) lacrime di sangue

|

| Una delle lettere di Vlad fornite dall'archivio romeno |

Vlad III è di sicuro un personaggio interessante, non solo per avere ispirato secoli Bram Stoker nel creare la figura di Dracula, ma per la sua storia di persona vissuta in tempi e, soprattutto, un’area difficile come la Valacchia, area che dire di frontiera è riduttivo. Personaggi duri per tempi duri, in attesa che le anime belle di matrice anglosassone ne impongano l’oblio per il non essere conformi al canone (forse meglio dire, il conformismo) del politicamente corretto e del woke. Per ora rimaniamo con personaggi come Attila, Dracula e Gengis Khan tuttora eroi nazionali in Ungheria, Romania e Mongolia, rispettivamente (del resto anche Nerone ha goduto di fama pessima, ma falsa, fino alla fine del XX secolo). Di seguito uno dei migliori libri storici su Vlad III.

|

| Uno dei passaggi dell'analisi. A sinistra una delle lettere e a destra l'analisi effettuata con luce UV sulla lastra di acetato per mappare la presenza di aminoacidi come triptofano, tiroxina e fenilalanina (image credit: MGG Pittalà et al, Anal. Chem. 2023) |

Schizofrenia. Mutazioni de novo durante l'embriogenesi

Non è invero chiaro se sia l'uso di droghe a causare i sintomi nelle persone a rischio o se siano le persone suscettibili alla schizofrenia più a rischio di far uso di droghe.

Per approfondimenti vi rimando all'articolo "Polymorphisms in Dopaminergic Genes in Schizophrenia and Their Implications in Motor Deficits and Antipsychotic Treatment"

Tra i geni coinvolti C4 è considerato tra i più importanti fattori di rischio.

Probabile invece che sia la combinazione di più varianti in diversi geni a rendere le persone a rischio. A rischio non vuol dire (come invece nel caso di mutazioni nei geni BRCA) la certezza di malattia proprio perché esistono dei "trigger" (inneschi) ancora poco compresi.

Si trattava però di associazioni riferite ad un numero di pazienti abbastanza basso (il 4% del totale) ad indicare la complessità sottostante del fenomeno (in quanto sia a varianti geniche ignote che ad eventi ambientali), fatto questo che minava anche le potenzialità diagnostiche. Dati in ogni caso nettamente migliori rispetto a quelli ottenuti dallo studio di altre patologie neuro-psicologiche (ad esempio il disturbo depressivo maggiore su cui una mega-analisi del 2013 fallì nell'identificare varianti geniche associate al rischio malattia.

Ad esempio una delle varianti geniche identificate (pur se con statistica affidabile) era presente nell'86,4% dei pazienti e nell'85% del gruppo di controllo.

Nota. La non origine germinale della mutazione si evince dalla assenza della stessa in altre cellule, correlate o meno, dello stesso individuo. In questo particolare caso le mutazioni di NRXN1 sono state trovate in una percentuale di cellule ematiche compresa tra il 14 e il 43%. Tale valore indica che la mutazione deve essere avvenuta nei primi giorni di sviluppo dell'embrione quando si stavano formando i precursori (staminali) che avrebbero poi, oltre ovviamente alle cellule coinvolte nel cablaggio neurale, il sistema emopoietico,

Alti livelli di caffeina ematica riducono il rischio di obesità e di diabete di tipo 2?

Varianti associate a minor metabolismo della caffeina rallentano la velocità di rimozione della molecola dal sangue e questo spiega i livelli alti in assenza di una dieta appositamente arricchita di fonti di caffeina. Anzi, le persone portatrici di tali varianti genetiche bevono, in media, meno caffè, proprio perché hanno meno bisogno di "rimpolpare" la caffeina eliminata.

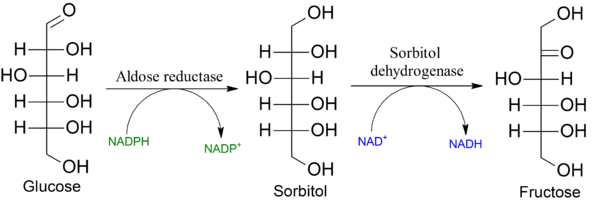

Fruttosio e Alzheimer. Nesso causale conseguenza dell'evoluzione o pura coincidenza?

Meno convincente invero l'ipotesi dei ricercatori che la tendenza dei malati a vagare senza meta sia vestigiale della attività di ricerca del cibo.

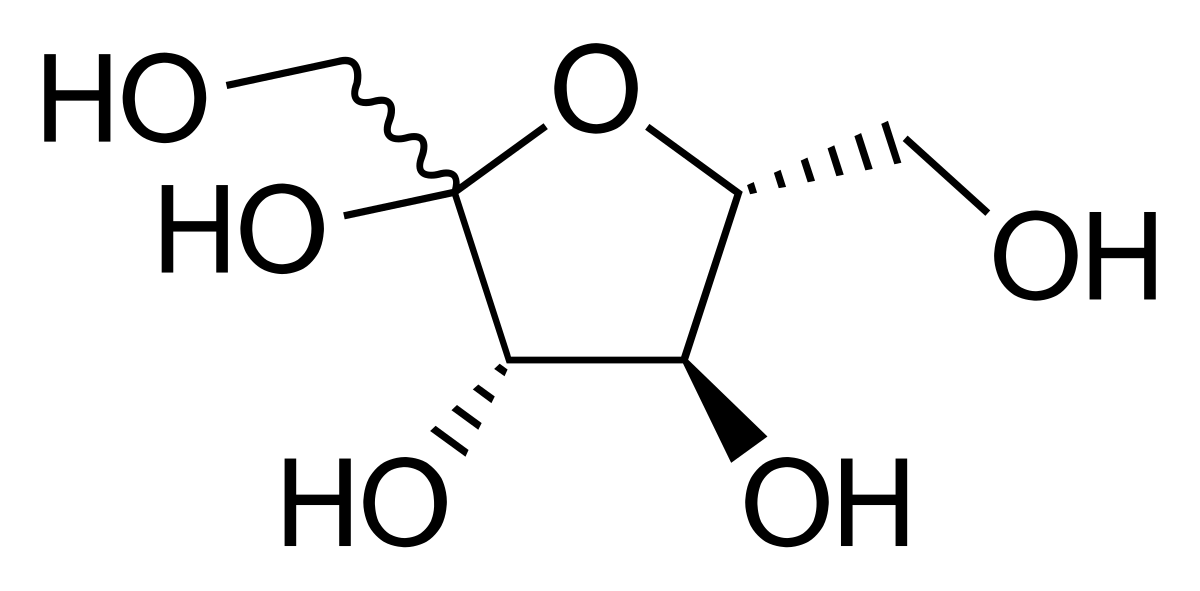

|

| Fruttosio |

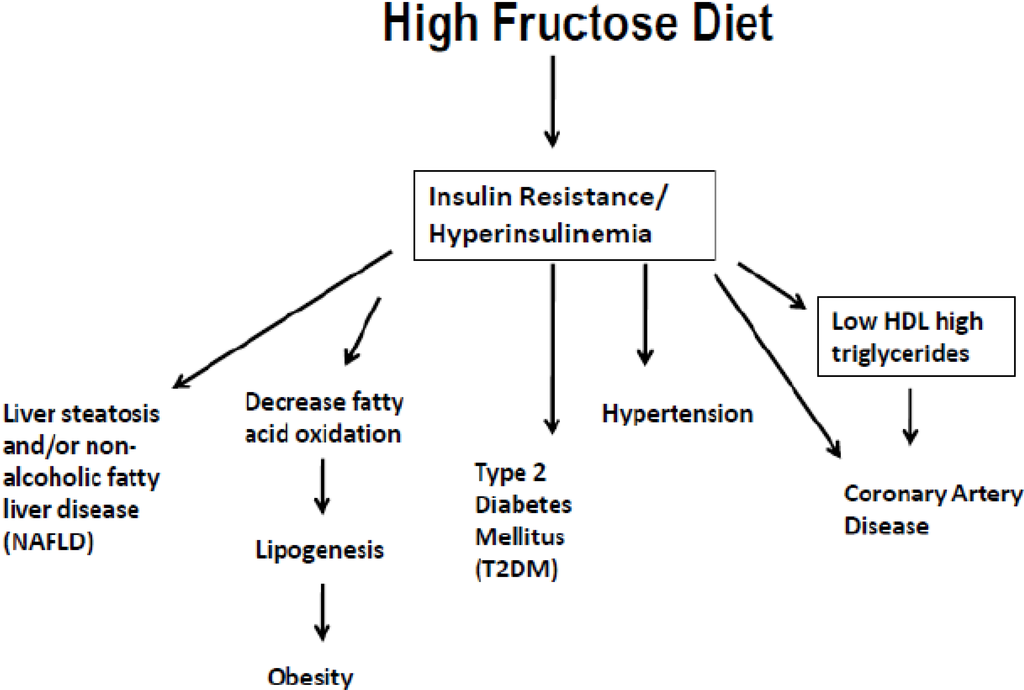

Fin qui niente di male, purché (ma questo vale per tutto) il prodotto venga usato in modo quantitativamente "intelligente".

- Ha un elevato potere dolcificante (tre volte superiore a quello del saccarosio) il che teoricamente dovrebbe spingere il consumatore ad usarne di meno. Vero però che una volta "cotto" (come avviene nelle preparazioni industriali) il suo potere dolcificante diminuisce, quindi il consumo reale aumenta e con esso il carico glicemico (soprattutto grazie al numero di prodotti che contengono fruttosio).

- Ha un basso indice glicemico (il che è buono) che si accompagna ad una sostanziale incapacità di attivare la produzione di insulina, al contrario del glucosio. D'altra parte, sebbene sia in grado di stimolare la sintesi dei lipidi (vedi sotto) non ha alcun effetto sulla produzione della leptina, l'ormone della sazietà, aumentando così il rischio di mangiare più del dovuto

- Tra le ragioni del basso indice glicemico vi è il suo scarso assorbimento da parte dell'intestino, assorbimento dipendente da un trasportatore (GLUT5) diverso da quello usato dalle cellule per il glucosio. Dato che il fruttosio viene assorbito lentamente e in modo variabile (alcuni individui hanno deficit di GLUT5), il suo accumulo intestinale favorisce il metabolismo batterico locale con disturbi facilmente immaginabili.

- A differenza del glucosio, metabolizzabile da ogni cellula, il fruttosio è usato principalmente dal fegato che lo stabilizza sotto forma di glicogeno, previa conversione in glucosio, pronto per essere mobilizzato in caso di bisogno. In condizioni normali il fruttosio viene convertito per la maggior parte in glucosio (54%), glicogeno (18%), lattato (15%) e meno dell'1% in trigliceridi. Di questi solo il glucosio e il lattato fungono da "combustibile" usato dalle altre cellule del corpo. Se c'è troppo fruttosio, la capacità trasformativa del fegato viene saturata e quello in eccesso viene trasformato in grasso, soprattutto nei soggetti con ipertrigliceridemia e diabete, innescando così problemi a cascata.

- In condizioni normali la quantità di fruttosio assunta è ben al di sotto della soglia di rischio. Vale la pena ricordare però che se per assumere 50 grammi di fruttosio servono 5 mele (difficile che qualcuno ne mangi così tante in una volta sola... senza danni), la stessa quantità si ottiene bevendo qualche bicchiere di succo di frutta. Quindi i "limiti naturali" che ben funzionavano in passato sono oggi inefficaci, specialmente con la dieta estiva.

- Il fruttosio è insieme al glucosio il monosaccaride più "usato" dal nostro organismo.

- Mentre il glucosio è spesso inglobato in molecole a diverso grado di complessità (ad esempio nel saccarosio, amido, glicogeno, etc) e quindi deve essere reso disponibile per scissione enzimatica, il fruttosio è pronto per essere usato.

- Il fruttosio grazie al suo elevato potere dolcificante è ampiamente usato nella industria alimentare (sotto forma di High Fructose Corn Syrup). E' inoltre uno zucchero "di moda" (lo potete vedere spesso sui banconi dei bar) visto il minore apporto calorico e il minore indice glicemico.

Il fruttosio uno degli zuccheri più presenti nella frutta e nel miele rappresenta il lato oscuro di una alimentazione apparentemente salutista quale quella di chi mangia molta frutta.

Il fruttosio uno degli zuccheri più presenti nella frutta e nel miele rappresenta il lato oscuro di una alimentazione apparentemente salutista quale quella di chi mangia molta frutta. Alla fine del periodo i ratti sono stati analizzati in quanto a capacità mnemoniche attraverso il test del labirinto (T-Maze test). E' ben noto che i ratti messi in un ambiente nuovo inizieranno ad esplorarlo e ne memorizzeranno i punti chiave; una capacità che permette loro di imparare, attraverso un processo di errore e apprendimento, a trovare la strada per uscire da un labirinto semplificato. Il labirinto è contrassegnato di segnali visivi in modo da facilitare il roditore nel ricordare i punti già visitati.

Alla fine del periodo i ratti sono stati analizzati in quanto a capacità mnemoniche attraverso il test del labirinto (T-Maze test). E' ben noto che i ratti messi in un ambiente nuovo inizieranno ad esplorarlo e ne memorizzeranno i punti chiave; una capacità che permette loro di imparare, attraverso un processo di errore e apprendimento, a trovare la strada per uscire da un labirinto semplificato. Il labirinto è contrassegnato di segnali visivi in modo da facilitare il roditore nel ricordare i punti già visitati.- limitare al massimo il consumo di fruttosio (soprattutto nei suoi usi più nascosti come ecciente)

- sostituire gli spuntini classici con bacche e yogurt greco (di cui ha una scorta anche sul lavoro).

- Nel caso sia disponibile non disdegna una bella barretta di cioccolato fondente (dall'80% in su meglio se amaro).

- Se poi proprio appartenete al gruppo di persone che non trattenersi da limitare l'uso sacrosanto di frutta (e via anche di un po di dolciumi) allora complementate la vostra dieta con alimenti ricchi di omega-3 come salmone, noci, alcuni oli vegetali (esempio di lino) oppure una pastiglia di DHA (1 grammo al giorno).

Fonti

Bene.

Articolo di riferimento

Sweet taste receptor signaling in beta cells mediates fructose-induced potentiation of glucose-stimulated insulin secretion

GA Kyriazis et al. Proc. Natl. Acad. Sci. U.S.A. 109, 10.1073 (2012)

Etichette

Clive S. Lewis

"Il concetto di probabilità è il più importante della scienza moderna, soprattutto perché nessuno ha la più pallida idea del suo significato"

Bertrand Russel

"La nostra conoscenza può essere solo finita, mentre la nostra ignoranza deve essere necessariamente infinita"

Karl Popper