L'ascolto della musica produce in noi molto più che un semplice apprezzamento estetico.

|

| credit: pixabay |

Non sorprende quindi l'interesse delle neuroscienze in tale ambito: indagare cosa succede nel nostro cervello quando ascoltiamo la musica ci permette di capire il legame tra aree funzionalmente diverse come quelle sensoriali, analitiche e di memoria.

Dalla analisi delle reazioni emotive ad una particolare musica alle ragioni per cui non riusciamo a "liberarci" dal canticchiare un motivetto ascoltato una sola volta per radio, c'è solo l'imbarazzo della scelta per chi voglia studiare l'effetto della musica sul cervello.

Ma cosa succede quando "sentiamo" la musica nelle nostre teste? Al netto dei casi patologici (tipici di alcune schizofrenie in cui i pazienti sperimentano vere e proprie allucinazioni uditive) il fenomeno non è infrequente anche tra chi non si occupa professionalmente di musica. Se chiudiamo gli occhi possiamo sentire il nostro motivetto preferito senza nemmeno canticchiarlo; una "dote" particolarmente sviluppata nei musicisti e in particolar modo nei compositori, capaci di creare/ricreare nella mente brani molto complessi e solo poi codificarli per iscritto su uno spartito.

I ricercatori svizzeri della EPFL si sono concentrati proprio su questo aspetto, cioè il capire cosa avviene nel nostro cervello quando ricreiamo mentalmente la musica. La speranza è che una volta sviluppati strumenti capaci di leggere prima il segnale cerebrale della musica "pensata" e tradurlo poi in suono reale, questi potranno essere utilizzati per aiutare le persone che hanno perso la capacità di parlare. La "cattura" del pensiero musicale è un punto di partenza ideale in quanto ha il vantaggio di essere universalmente compresa mentre il linguaggio necessita di sovrastrutture ben più difficili da decodificare.

L'elaborazione neurale di un suono è un fenomeno complesso, per il numero di passaggi necessari alla cattura (apparato uditivo esterno ed interno, con la coclea che scompone e analizza i suoni a diversa frequenza generando infine il segnale nervoso) e alla elaborazione cerebrale del segnale elettrico veicolato dal nervo uditivo.

Per avere una idea della quantità di informazioni elaborate è sufficiente pensare al numero di processi che avvengono pressoché in contemporanea durante l'ascolto: il cervello è in grado di capire la direzione del suono dalla comparazione tra il segnale percepito dall'orecchio sinistro e destro, interfacciarsi con gli altri sensi per individuarne l'origine, scomporlo in modo da isolare la parte vocale dal rumore di fondo, identificare una voce in particolare tra le tante presenti, capirne il senso (alcune lesioni cerebrali fanno perdere questa capacità nonostante l'udito e le capacità intellettive siano normali) e non ultimo riconoscere l'identità dell'interlocutore nonostante le variabili tonali del caso.

La tecnologia ha fatto passi da gigante negli ultimi anni ma come evidente dalle difficoltà che spesso riscontrano le AI presenti sui nostri telefoni, c'è ancora molto da fare soprattutto se si pensa che si tratta solo di analisi vocali incapaci di analisi semantiche.

Mentre l'analisi di un suono è tutto sommato un processo diretto, cosa ben diversa è la lettura dei segnali cerebrali associati al suono e soprattutto la identificazione del suono "pensato", che sposta il target analitico da una analisi funzionale di un suono "reale" ad una vera e propria analisi del pensiero.

Mentre l'analisi di un suono è tutto sommato un processo diretto, cosa ben diversa è la lettura dei segnali cerebrali associati al suono e soprattutto la identificazione del suono "pensato", che sposta il target analitico da una analisi funzionale di un suono "reale" ad una vera e propria analisi del pensiero.

Vedi articolo precedente --> "MRI e lettura del pensiero"

Se durante l'analisi dell'attività cerebrale su un individuo che sta ascoltando musica la correlazione suono-attività neurale è di "facile" rilevazione, quando la musica è solo nella nostra testa, quel suono in realtà non esiste quindi i potenziali errori interpretativi sono molteplici. Non basta che un soggetto dica "sto ricreando il motivetto centrale della Carmen di Bizet", bisogna innanzitutto capire quanto il pensiero di quella data musica sia coerente con l'originale (esempio classico è la distonia tra l'essere stonati e il non accorgersi di esserlo).

Per ovviare a tali problemi i ricercatori necessitavano di un soggetto "affidabile", nel senso di un individuo con competenze musicali (teoriche e pratiche) adeguate. Persona individuata in un pianista esperto quando si rivolse ai medici per cercare di trovare rimedio ad una epilessia refrattaria ai trattamenti standard.

Perché non cercare direttamente musicisti senza aspettare che venisse un paziente "adatto"? Il problema è nell'invasività delle tecniche analitiche necessarie per identificare i circuiti neurali interessati. Non sarebbe stato etico farlo su dei volontari mentre su un paziente che già di suo doveva sottoporsi ad una serie di esami molto approfonditi per identificare le aree epicentro degli attacchi epilettici, l'analisi non avrebbe comportato interventi aggiuntivi se non quelli legati al test. Resta inteso che anche qui è centrale (e non forzata da situazioni contingenti) la volontarietà del soggetto a partecipare allo studio.

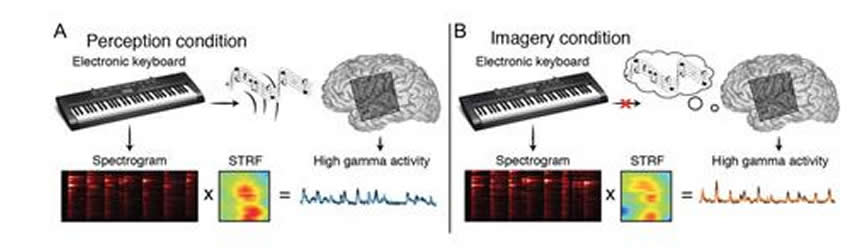

Al paziente fu chiesto per prima cosa di suonare un brano musicale su una tastiera con il suono attivato. Questo passaggio serviva per registrare l'attività cerebrale derivante dall'ascolto della musica che il pianista stava (consapevolmente) producendo. Creata la base di comparazione, si chiese al paziente di ripetere lo stesso pezzo con il volume della tastiera disattivato, pensando alla musica che stava eseguendo. Niente di più semplice e naturale per un musicista.

Anche in questo caso l'attività cerebrale venne registrata associandola alla musica che veniva (silenziosamente) prodotta dalla tastiera. Il procedimento venne ripetuto con diversi brani in modo da avere una sorta di "traduttore" del segnale cerebrale per la musica o più semplicemente il legame tra un suono "pensato" e un dato segnale neurale.

|

| all credit to: Stephanie Martin et al, Cerebral Cortex (2017) |

La tecnica analitica usata è la elettrocorticografia, una procedura ben più invasiva della risonanza magnetica funzionale (usata in test simili) in quanto richiede l'impianto di sottili elettrodi in profondità nel cervello del paziente allo scopo di mappare le regioni attivate dal processo in esecuzione. La tecnica è usata principalmente per il trattamento di pazienti epilettici laddove la farmacologia sia inefficace; da qui la scelta di aspettare di trovare un soggetto adatto (un musicista) per cui fosse già prevista la elettrocorticografia.

Lo studio è stato pubblicato sulla rivista Cerebral Cortex. I risultati sono chiaramente preliminari e ben lungi dall'essere applicabili per la creazione di "convertitori" della musica pensata in sonorità complesse ma la prova di fattibilità è stata superata.

Ci vorrà invece ancora molto tempo prima di sviluppare elaboratori vocali del pensiero (o meglio di una frase pensata). La lingua è un sistema molto più complicato della musica in quanto l'informazione linguistica non è universale ed avviene in molteplici passaggi.

Altro limite della tecnica qui usata è la sua invasività, accettabile solo perché contingente ad altri interventi ma impensabile nella quotidianità.

Il primo passaggio sarà cercare di replicare questi risultati con i pazienti afasici - persone che hanno perso la capacità di parlare - e verificare se, e quanto affidabilmente, i suoni pensati potranno essere ricreati.

Fonte

- Neural Encoding of Auditory Features during Music Perception and Imagery

Stephanie Martin et al, (2017) Cereb Cortex. 1-12

Nessun commento:

Posta un commento